HOME > AI活用とAEO・AIO > 「AIによる概要」の答えはどこまで信じていいか?信憑性を見極める視点

「AIによる概要」の答えはどこまで信じていいか?信憑性を見極める視点

2025年10月25日

最近、SEOコンサルティングのクライアントさんや全日本SEO協会の会員さんから、「AIによる概要に出ている答えが正しいかどうか、どう判断したらいいか?」という相談が増えてきています。たとえば、「検索上部に『AIによる概要』で説明らしき答えが出ているけれど、他サイトでは異なる内容が書かれている」などのケースです。

確かに、Google検索結果の一番上に AIが自動で要点をまとめて示す「AIによる概要」が出ると、ユーザーはそれを「権威ある答え」だと思いがちです。しかし、実際にはその要約に誤りが含まれたり、文脈を誤解していたりすることも少なくありません。

この記事では、私がこれまでのコンサル経験や調査をもとに、「AIによる概要の答えの信憑性(=どこまで信じられるか)」をテーマに、信憑性を判断するための視点、リスク、そしてサイト運営者側としてできる工夫をわかりやすく解説します。

なぜ 「AIによる概要」の答えに「誤り」が含まれうるか?

「AIによる概要」は極めて強力なツールですが、誤りを含みうる構造的なリスクを持っています。以下、その主な理由を整理します。

(1)「要約」の性質ゆえの省略・補完

「AIによる概要」は、複数のウェブ情報を取り寄せて、それらを統合し、要点を抽出・再構成して提示します。このプロセスで、文脈の省略、前後の結びつきの省略、補完(埋め込み)によって 「本来の意味」 が変容してしまうことがあります。

たとえば、元のソースで複雑な条件付き説明があったにも関わらず、AIがそれを「断定文」に変えてしまったりするケースです。要点だけを取ると「条件」の部分が抜け落ちることは、生成要約型システムの典型的な問題です。

このような「要約ゆえのズレ」は、学術界でも指摘されており、自動要約が原文と整合性を失うリスクについて研究論文が多数あります。たとえば 「Improving Factual Consistency of Abstractive Summarization」 という論文では、この種のずれ・誤りを減らす技術的対策が議論されています。

(2)「幻覚 (hallucination)」 の発生

AIによる概要は、訓練済みモデルの言語予測力を使って文章を生成しますが、ときどき 「存在しない事実」 を紛れ込ませる、いわゆる「幻覚 (hallucination)」 が発生することがあります。特に、情報源が曖昧だったりデータが不足していたりする分野では、AIが「もっとらしい文」を作ってしまうことがあります。

実際、ニュースやテックメディアでも、「Google 的な AI概要が自信満々に誤った結論を出した」例が報じられています。たとえば TechRadarは、「Google の AI 概要はしばしば自信たっぷりに間違った結論を提示する」可能性を指摘しています。

《出典》 Google's AI Overviews are often so confidently wrong that I've lost all trust in them(TechRadar)

また、SEO.com の記事 「When (And Why) AI Overviews Get It Wrong」 では、皮肉・比喩・ジョーク表現を誤解するケース、情報ソースが古いまたは対立しているケースが要因として挙げられています。

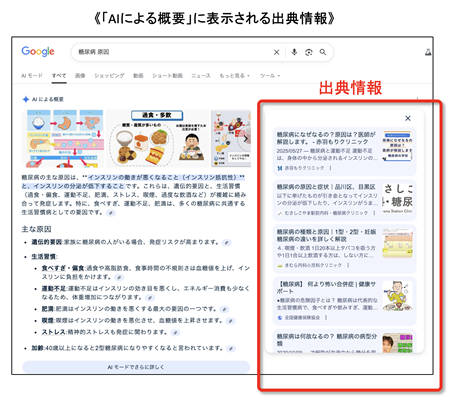

(3)出典引用ミスマッチ・誤引用

「AIによる概要」はしばしば出典を示しますが、その出典が「主張を支える根拠」ではないケースもあります。AIが 「その文に対する正しい出典」 を慎重に選べず、「この文に近い語句を含むページ」を引用してしまうことがあるのです。

また、ある出典を示していても、その出典ページ自体が正しくない・誤っている可能性もあります。こうした「誤引用・信憑性低いソース」混入リスクも無視できません。学術的な研究でも、生成型検索エンジンにおける「検証性 (verifiability)」は重要課題とされており、生成文中のすべてのステートメントが正しく引用可能であること、引用が精確であることが求められます。

ある研究 「Evaluating Verifiability in Generative Search Engines」 では、多くの生成回答において、文の半分程度しか適切に引用されていない実態が示されています。

(4)情報更新遅延・データ古さ

「AIによる概要」は、インデックスされた情報や訓練データをもとに生成されますので、最新情報が反映されていないことがあります。特に、ニュース、統計データ、法令改正など「時間が重要な分野」では、古い情報がそのまま答えとして出てくるリスクが高まります。

実際、Kiplinger の報告によると、「生命保険 (life insurance)」というテーマで調査したところ、Google の AI 概要回答の 57% に誤りが含まれていたというケースも報告されています。

《関連情報》 コンテンツの鮮度を高めることが上位表示にプラスに働く

このように、「AIによる概要」は「便利さ」と「リスク」が表裏一体であり、ユーザーも制作者も「信憑性を疑いながら使う視点」が求められます。

「AIによる概要」の信憑性を判断するためのチェックリスト

ここからは、検索者(読者)目線、およびサイト運営者目線で、「AIによる概要」の答えを信じていいかどうかを見極めるための具体的なチェックポイントを紹介します。

(A)検索者・一般ユーザー向けチェック

1. 出典リンクを確認する

概要本文に出典が示されていれば、そのリンク先を実際に訪れて、主張内容が出典に即しているかを確かめる。

2. 複数のサイトで同様の主張がされているか

AIの答えが他サイトでもほぼ同じように言われているなら信憑性が高まる。ただし「どこも間違っている」可能性もあるため注意。

3. 日付・最終更新を確認する

統計や法律・政策に関する答えなら、最新版かどうかをチェックする。

4. 文脈や前提条件に注意

AIが答えを単純化してしまっていることも多い。たとえば「〇〇ならば…」という条件を読み飛ばしていないかを見る。

5. 怪しい言葉遣い・断定調に注意

「必ず〜する」「絶対〜だ」といった強い断定表現があれば、慎重に。AIは信念を持って答えを生成しないので、断定表現は常に警戒材料になります.

(B)サイト運営者・ライター目線チェック — 信憑性を高めるために

1. 根拠出典を丁寧に示す

主張・数値・事例には必ず信頼できる出典(学術論文、公式機関、調査レポートなど)を示し、リンクを張る。

2. 前提条件や制約を明記する

「〜の場合」「条件付き」「例外あり」など、すべての前提を明示しておく。

3. 最新情報を確保・定期更新する

日付表示・最終更新日時を明示し、内容をできるだけ最新のものに保つ。

4. 複数の情報源を併用する

1つの調査に依存せず、複数の信頼ソースを参照し、整合性を持たせる。

5. 判例・現場経験を交える

私自身のコンサル現場事例や会員からの相談経験を入れることで、「AIによる概要」にない 「現実的視点」 を補える。

6. 構造化データ・スキーマを活用

可読性だけでなく、構造データ (schema.org など) を使って情報の意味を明示しておくと、AIにも「この情報はこういう意味だ」と認識されやすくなります。

《関連情報》 構造化データとは?そのSEO上の意味と重要性

7. 「AIによる概要」に出やすい項目を意識して配置する

「見出し → 質問形式 → 要点をまとめる箇条書き」 など、AIが答えを取り出しやすい構造を設計する。たとえば「〜とは何か?」「〜の注意点」など見出し形式を使う。

現場で実際に起きている「AIによる概要」の誤り事例

私のところには、SEOコンサルティングを受けている企業や全日本SEO協会の会員から、「AIによる概要の内容が間違っていた」「自社が出した情報が正しいのに、AIが違う情報を採用している」という相談が寄せられることがあります。

たとえば、ある不動産会社のクライアントは、地域の住宅ローン制度について正確な情報を掲載していました。ところが「住宅ローン 控除 東京都」で検索すると、AIによる概要に「現在は最大20年の控除期間」と出ており、実際の制度変更後の「最大13年」とは異なっていました。これは、AIが古い行政ページをソースに要約したためです。

また、別の医療機関の会員からは、「AIによる概要で『風邪に抗生物質が有効』と出ていた」という報告がありました。もちろんこれは誤りです。AIは信頼性の低い掲示板投稿や医療ブログを拾ってしまった可能性があります。

こうした事例を通して感じるのは、「AIによる概要の答えが間違っていること自体よりも、それを「正しいと思い込むユーザー」が増えていること」の方が深刻だという点です。検索画面の最上部に出る情報ほど、人は無意識に信頼してしまう傾向があります。この「トップ表示の権威性」がAI要約に加わった結果、誤った情報が広まりやすくなっているのです。

信憑性の低下は「AI」だけでなく「人間側の問題」でもある

私がSEOコンサルティングの仕事をする中で感じるのは、「AIによる概要」の信憑性問題は単にAI側の責任ではなく、私たちWeb制作者側にも原因があるということです。

多くのサイトが「オリジナルな一次情報」を持たず、他サイトの要約をさらに要約しているため、AIが信頼できる情報を探しても「本物の根拠」を見つけにくいのです。要するに、ネット全体が「薄い情報の循環」に陥っているのです。

私はある教育系の協会の会員に対して、「AIに正確な情報を出してほしいなら、まず自分のサイトに「確実に正しい情報源」を置くことが先だ」とアドバイスしています。これはSEOでもまったく同じです。Googleのアルゴリズムは「権威あるサイトからの引用」「一次情報の存在」「専門家の監修」を重視しており、AIによる概要の生成でも同じ基準が使われているのです。

「信頼されるAIの引用先」になるためのSEO戦略

では、どのようなサイトがAIによる概要に正確に引用されやすいのでしょうか。私の経験上、AIが「信頼に足る」と判断するサイトには共通点があります。

(1)情報の出典と更新履歴を明記している

「出典:」「最終更新日:」を明記するだけで、AIは「この情報は確認可能(verifiable)」と判断しやすくなります。Googleの開発者ドキュメントでも、「AIによる概要が参照する可能性のあるサイトは、明確な出典・日付・構造を持つことが望ましい」と明記されています。

(2)専門家の意見・実体験を含んでいる

E-E-A-Tの中でも特に「Experience(経験)」が重要です。実際に現場で得た知見、顧客の声、写真、データなどを掲載している記事は、AIから「実際の体験を伴うコンテンツ」として高く評価されます。

(3)構造化データを正しく設定している

FAQ構造化データ、Article構造化データ、Review構造化データなどを使うと、AIが「記事の文意」を誤解しにくくなります。AIが正確に答えを生成するには、機械が「意味」を理解できるページ構造が欠かせません。

(4)誤情報を訂正する文化を持っている

間違いを見つけたら追記・修正し、訂正履歴を明示する。AIは「透明性」を重視します。修正履歴があるサイトは、AIに「信頼性の高い発信者」と見なされやすいのです。

SEOと信憑性は表裏一体

SEOを突き詰めると、最終的には「信頼性(trust)」に行き着きます。これは人間に対しても、AIに対しても同じです。かつてのSEOでは、キーワードや被リンクが主な要因でしたが、今は「AIが引用したいサイト」かどうかが評価基準になりつつあります。つまり、「AIによる概要の中に登場する権威ある情報源」として扱われることが、今後のSEO最大の目標のひとつになるでしょう。

Googleの公式ドキュメントでも、「AIによる概要は、信頼性と品質を最優先に設計されている」と明言されています。

したがって、今のSEOで求められるのは「AIにとって信頼できるサイトを作ること」です。技術的SEOだけでなく、人間が信じられるコンテンツ=AIも信じられるコンテンツ を作るという発想が必要なのです。

「AIによる概要」の信憑性は『人が育てる』もの

AIによる概要がどれだけ進化しても、それを正しく導くのは結局、人間が作る情報です。AIは人間が書いたテキストをもとに学習し、要約し、答えを提示します。つまり、「AIによる概要の信憑性」は、私たちがどれだけ正確で誠実な情報をネット上に提供しているかにかかっています。

SEOの未来は、「AIに好かれるテクニック」ではなく、「AIに信頼される誠実さ」の時代になると私は考えています。誤りのない、検証可能な情報を出し続けること。体験に基づく独自の知見を語ること。そして、ユーザーに誠実に向き合うこと。

これらの積み重ねが、「AIによる概要」の中でも「このサイトは信頼できる」と評価される最も確実な道です。AI時代のSEOとは、技術よりも「信頼の構築」で勝負する世界です。あなたのサイトがAIにとっても、そして人間にとっても「信頼される存在」であること——それこそが、これからの検索の主戦場であり、真のE-E-A-Tの実践だと私は確信しています。

鈴木将司の最新作品

プロフィール

フォローしてSEOを学ぼう!

| << 2025年 10月 >> | ||||||

|---|---|---|---|---|---|---|

| 日 | 月 | 火 | 水 | 木 | 金 | 土 |

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 | |

最新記事

- 「新宿の矯正歯科」というクエリでAIモードに表示される方法

- AIモードで「池袋のエステサロン」と検索した時に表示される条件

- AIモードで「横浜駅周辺のパーソナルトレーニングジム」で検索した時に上位表示されるサイトの条件

- AIモードで取り上げられる整体院は何が違うのか?「川崎市の腰痛治療に強い整体院は?」で検証

- AIモードの使い方を初心者向けに完全解説【従来検索との違いもわかる】

- AI検索時代、ユーザーはどう商品・サービスを購入するのか?質問から始まる「新しい購買プロセス」

- ChatGPT時代に「検索」と「SEO」はどう変わり始めているのか― OpenAI公式・経済研究レポートが示す時代の転換点

- ChatGPTは人々の「仕事」と「学習」をどう変えているのか― OpenAI公式・経済研究レポートが示す「静かな変化」

- ChatGPTは実際にどう使われているのか?― OpenAI公式・経済研究レポートから読み解く「利用実態の全体像」

- ChatGPT・AIモード・Perplexity ではどんな検索クエリが入力されているのか?AI検索時代の「問い」を分析する

アーカイブ

- 2026年01月

- 2025年12月

- 2025年11月

- 2025年10月

- 2025年09月

- 2025年04月

- 2025年02月

- 2025年01月

- 2024年12月

- 2024年11月

- 2024年10月

- 2024年09月

- 2024年08月

- 2024年07月

- 2024年06月

- 2024年05月

- 2024年04月

- 2024年03月

- 2024年02月

- 2024年01月

- 2022年06月

- 2022年04月

- 2022年03月

- 2022年01月

- 2021年12月

- 2021年11月

- 2021年09月

- 2021年08月

- 2021年07月

- 2021年06月

- 2021年04月

- 2020年12月

- 2020年11月

- 2020年09月

- 2020年08月

- 2020年07月

- 2020年06月

- 2020年05月

- 2020年03月

- 2020年02月

- 2019年12月

- 2019年11月

- 2019年10月

- 2019年09月

- 2019年08月

- 2019年07月

- 2019年06月

- 2019年05月

- 2019年04月

- 2019年03月

- 2019年02月

- 2019年01月

- 2018年12月

- 2018年11月

- 2018年10月

- 2018年09月

- 2018年08月

- 2018年07月

- 2018年06月

- 2018年05月

- 2018年04月

- 2018年03月

- 2018年02月

- 2018年01月

- 2017年12月

- 2017年11月

- 2017年10月

- 2017年09月

- 2017年08月

- 2017年07月

- 2017年06月

- 2017年05月

- 2017年04月

- 2017年03月

- 2017年02月

- 2017年01月

- 2016年12月

- 2016年11月

- 2016年10月

- 2016年09月

- 2016年08月

- 2016年07月

- 2016年06月

- 2016年05月

- 2016年04月

- 2016年03月

- 2016年02月

- 2016年01月

- 2015年12月

- 2015年11月

- 2015年10月

- 2015年09月

- 2015年08月

- 2015年07月

- 2015年06月

- 2015年05月

- 2015年04月

- 2015年03月

- 2015年02月

- 2015年01月

カテゴリー

- パンダアップデート(20)

- ペンギンアップデート(5)

- スマートフォン集客・モバイルSEO(42)

- Google検索順位変動(5)

- Youtube動画マーケティング(8)

- コンテンツマーケティング(13)

- Web業界の動向(22)

- デジタルマーケティング(14)

- SNSマーケティング(11)

- 成約率アップ(8)

- SEOセミナー(4)

- 認定SEOコンサルタント養成スクール(2)

- 上位表示のヒント(162)

- ビジネスモデル開発(5)

- Bing上位表示対策(1)

- SEOツール(16)

- ヴェニスアップデート(1)

- スマートフォンSEO対策(19)

- アップルの動向(3)

- 人材問題(4)

- Googleの動向(20)

- AI活用とAEO・AIO(56)

- ローカルSEOとGoogleビジネスプロフィール(20)

- ドメイン名とSEO(7)

- アルゴリズムアップデート(45)

- Webの規制問題(8)

リンク集